A Google DeepMind tanulási módszere révén a futball-robot játékosok egyre ügyesebbek

A Google DeepMind részlegének szakértői egy tanulási módszert alkalmaztak miniatűr robotokra, amelyeket a jövőben felhasználhatnak az embersegítő robotok kiképzésére.

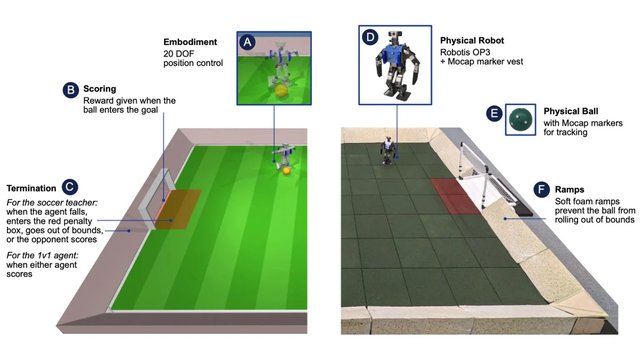

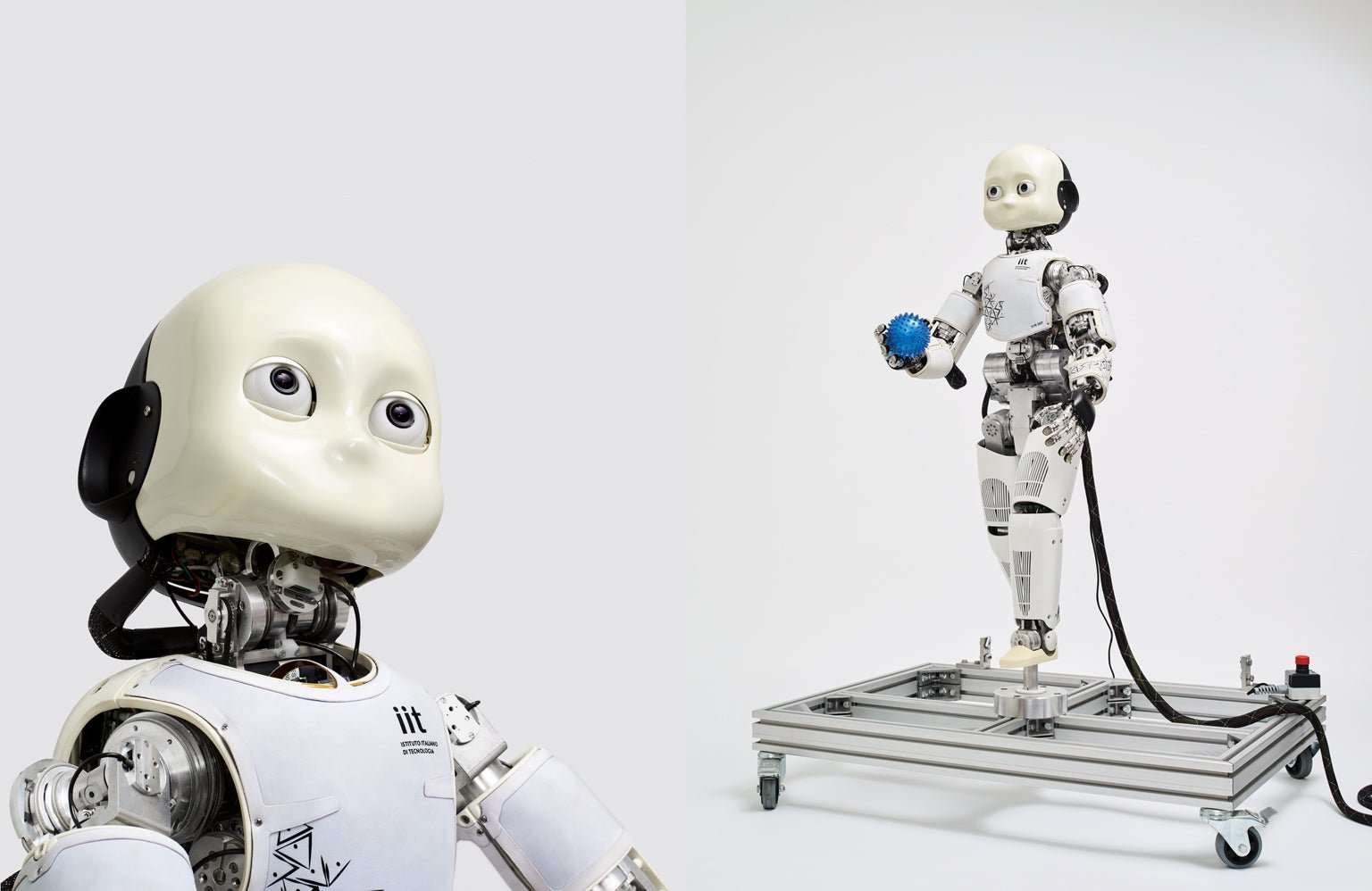

A mesterséges intelligencia és a robotika kutatói évek óta azon fáradoznak, hogy olyan általános intelligenciát hozzanak létre, amely lehetővé teszi a robotoknak, hogy ugyanolyan készséggel, mozgékonysággal és megértéssel navigáljanak a fizikai világban, mint az állatok vagy az emberek. A fejlesztés, amely évek óta zajlik, az utóbbi időben a mély megerősítő tanulásra (DLR) összpontosított. A munkájuk előrehaladását egy futballmeccs során mutatták be, amelyet robotok játszottak. Míg a négylábú robotok figyelemre méltó képességeket mutattak a labdarúgásban és a labdát irányító képességekben, kétlábú robotjaik még mindig ügyetlenek. Ez elsősorban az alapvető készségek miatt van, amelyekre a kutatóknak a stabilitás és a hardver korlátai miatt kell összpontosítaniuk. A DLR két tanulási stratégiát kombinál e kihívások kezelésére. A Google DeepMind kutatói ezt a megközelítést használva megpróbálták megtanítani az olcsó miniatűr robotokat, hogy focizzanak és egymással versenyezzenek. A kísérletek eredményeit, amelyeket mind szimulált, mind fizikai környezetben végeztek, a Science Robotics tudományos folyóiratban publikálták. A kezdeti hangsúly két területre irányult: az egyik arra, hogy a robotok hogyan tudnak felállni a földről, a másik arra, hogy hogyan tudnak gólokat szerezni a képzetlen ellenfelek ellen. A megerősítő tanulás hatékonynak bizonyult, mivel a robotok gyorsan megtanultak felállni, járni, megfordulni és pontosan rúgni, valamint könnyedén váltani ezek között a cselekvések között. Ez az érdekes mérnöki tanulmányban foglalja össze. Továbbá egy robot képes volt megakadályozni az ellenfél dobását, és előre megjósolni a labda mozgásának irányát. A szakértők szerint a készségek manuális fejlesztése nem lenne praktikus, mivel a robotnak mindig adaptív módon kell reagálnia a körülményekre. A szakértők megállapították, hogy a szimulált környezetben kifejlesztett mozgási stratégia könnyen átvihető valódi robotokra. A kísérleti mérkőzéseken az ezzel a módszerrel kiképzett robotok 181 százalékkal gyorsabban mozogtak, 302 százalékkal gyorsabban forogtak, 34 százalékkal gyorsabban rúgtak labdát, és 63 százalékkal gyorsabban álltak fel, miután elestek, azokhoz a készülékekhez képest, amelyek csak az alapszabályokat ismerik. A kutatók úgy vélik, hogy ez megnyitja az utat a humanoid robotok biztonságos mozgásának és bonyolult cselekedeteinek megtanítására dinamikus környezetben, új korszakot hirdetve a robotika segítségnyújtásának és az emberekkel való együttműködésének lehetőségében.

Translation:

•

Translated by AI